Digitalzoom 2.0 bei Smartphones: Ist ein "optischer Zoom" per Crop Unsinn?

Das iPhone 14 Pro hat vier Kameras, schreibt Apple auf der Produktseite – Hauptkamera, Ultraweitwinkel sowie Zweifach- und Dreifachzoom. Allerdings sind auf der Rückseite nur drei Kameras sichtbar. Die Lösung ist eine "virtuelle Kamera" mit Zweifach-Zoom, ermöglicht durch den 48-Megapixel-Quad-Pixel-Sensor. Ist das freches Marketing oder tatsächlich sinnvoll?

Es geht 2022 in die nächste Runde, das irrsinnige Megapixel-Rennen. Nachdem Ende 2019 das erste 108-Megapixel-Smartphone auf den Markt kam, fällt diesen Monat mit dem Motorola Edge 30 Ultra (Test) und Xiaomi 12T Pro (Hands-on) die 200-Megapixel-Marke. Und sogar das eben erwähnte iPhone 14 Pro ist dieses Jahr auf Apple-untypische 48 Megapixel gesprungen. Doch die spannende Eigenschaft extrem hochauflösenden Sensoren sind gar nicht die bis zu 100 Megabyte großen Fotos für Abzüge im Hauswandformat, sondern deren Zoom.

Wie funktioniert der 2x-Zoom im iPhone 14 Pro?

Im Gegensatz zu ausgewachsenen Digitalkameras haben die allermeisten Smartphones aus Platzgründen keine Zoomobjektive, die durch ein Verschieben der Linsen die Brennweite verändern können. Stattdessen gibt es für verschiedene Zoomstufen eigene Sensoren. Beim iPhone 14 Pro sind das ein Sensor für den Ultraweitwinkel (0,5x), einer für den Weitwinkel (1x) und einer für die Telekamera (3x).

Beim Zoomen per Zwei-Finger-Geste in der Kamera-App zoomt das Smartphone nun jeweils digital ins Bild einer Kamera hinein, bis die Vergrößerung des nächsten Kameramoduls erreicht ist – und schaltet dann um. Bei zunehmender digitaler Vergrößerung nimmt die Qualität natürlich ab. Der Grad der Abnahme hängt von der jeweiligen Kamera ab.

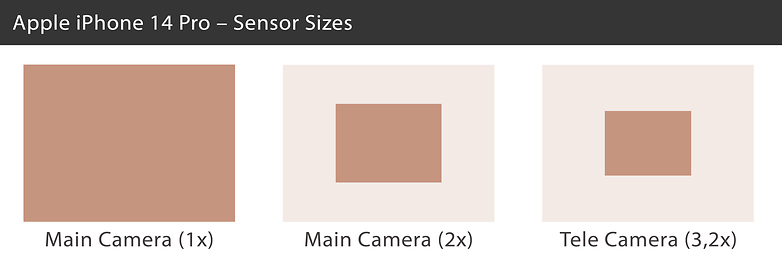

Im iPhone 14 Pro steckt als Hauptkamera ein 1/1,28-Zoll-Bildsensor, der 9,8 mal 7,3 Millimeter groß ist. Die Auflösung beträgt 48 Megapixel. Beim 2x-Zoom schneidet Apple einfach aus dem Sensor mittig einen 12-Megapixel-Ausschnitt heraus, der auf dem Sensor dann immer noch 4,9 mal 3,7 Millimeter misst – und damit etwa dem 1/3-Zoll-Format entspricht. Rechnerisch sind das immer noch Voraussetzungen für ordentliche Fotos bei guten Lichtverhältnissen.

Beim 3x-Zoom schaltet Apple dann auf den nächsten 12-Megapixel-Sensor um (der eigentlich mit einer Äquivalentbrennweite von 77 Millimetern eher bei 3,2x liegt). Mit dem 1/3,5-Zoll-Format beziehungsweise 4,0 mal 3,0 Millimetern ist der Sensor wieder ein Stückchen kleiner als der mittig aus der Hauptkamera ausgeschnittene "2x-Sensor".

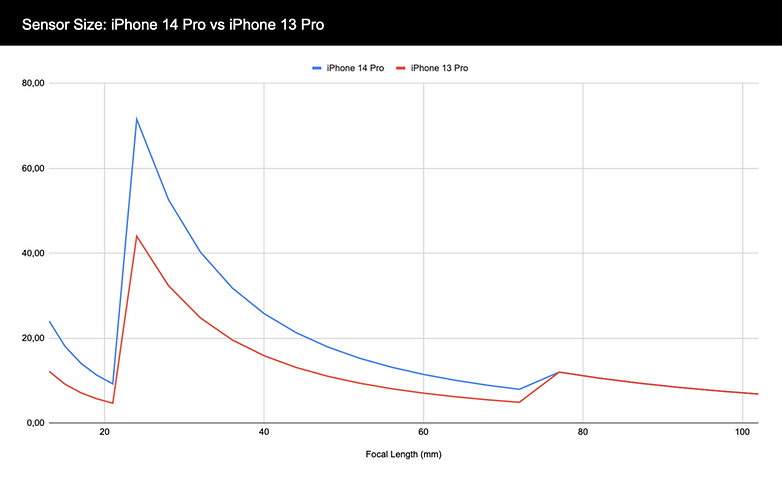

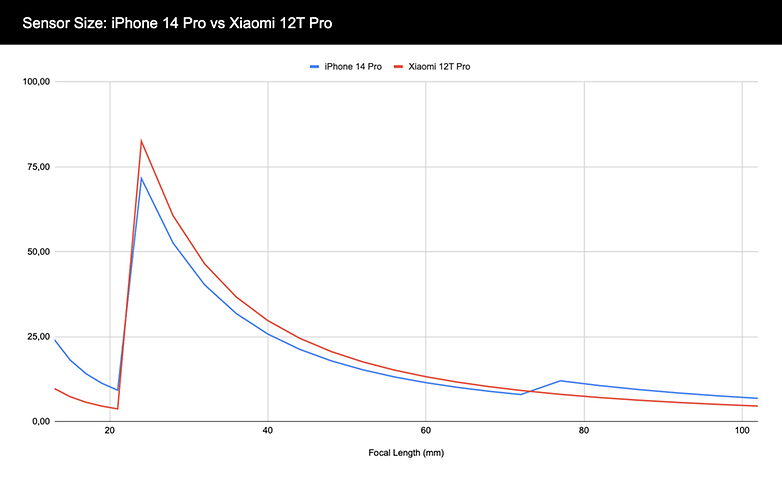

In der nachfolgenden Grafik seht Ihr, wie viel Sensorfläche der Kamera im iPhone 14 Pro und iPhone 13 Pro bei den unterschiedlichen Brennweiten zur Verfügung steht. Ganz links am Rand geht's im Ultraweitwinkel los (13 Millimeter). Bei der Hauptkamera (24 Millimeter) gibt's dann einen deutlichen Sprung nach oben. Bis zur Telekamera hin (77 Millimeter) hat das iPhone 14 Pro immer mehr Sensorfläche zur Verfügung als das iPhone 13 Pro. Die Telekamera schließlich ist identisch.

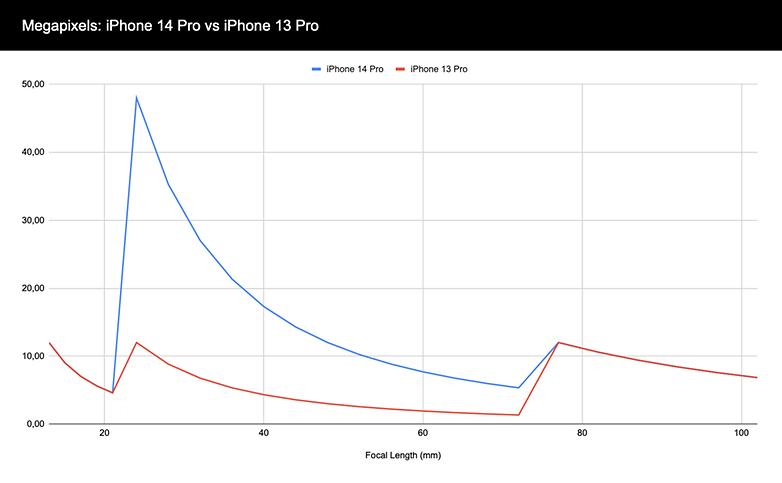

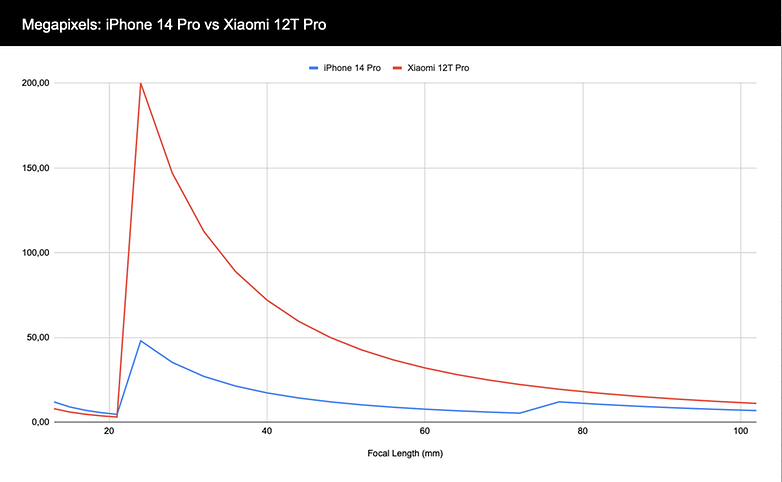

Interessant ist auch die obige Grafik, nur mit Megapixeln anstelle von Sensorfläche in der vertikalen Achse. Während der Verlauf im Ultraweitwinkel- und Telebereich mit jeweils 12 Megapixeln identisch ist, macht sich der Sprung auf 48 Megapixel deutlich bemerkbar. Das iPhone 14 Pro hat beim digitalen Zoom zwischen 1x und 3,2x deutlich mehr Auflösungsreserven.

Wie groß und hochauflösend muss es sein?

Das bislang diskutierte iPhone 14 Pro ist nicht einmal das Smartphone mit der höchsten Auflösung oder dem größten Sensor. Diese Woche hat Xiaomi das 12T Pro gelauncht, das einen 200-Megapixel-Sensor bietet – und dafür komplett auf eine Telekamera verzichtet. Aber wie viel mehr Spielraum für's digitale Zoomen bieten so viele Megapixel? Sehen wir's uns an im Vergleich mit dem iPhone 14 Pro:

Der neben der Auflösung noch wichtigere Faktor ist allerdings die Sensorfläche, die der Kamera bei den unterschiedlichen Brennweiten zur Verfügung steht. Der im Xiaomi 12T Pro verbaute Isocell HP1 ist mit 1/1,22 Zoll zwar deutlich größer als die Hauptkamera im iPhone 14 Pro, verliert beim Umschalten des Apple-Smartphones im Telezoom dann aber doch hinsichtlich der verfügbaren Sensorfläche:

Und was ist mit dem Quad-Bayer?

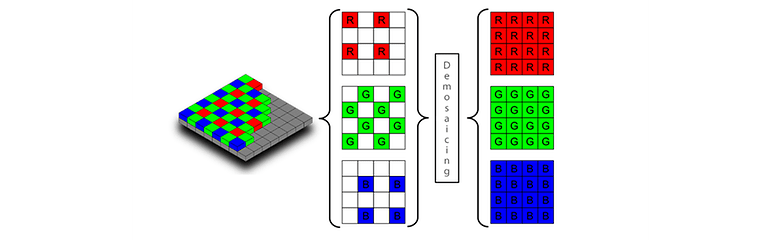

Einen Faktor haben wir außer Acht gelassen: die Farbmasken über dem Sensor. Um Quad-Bayer & Co. zu erklären, müssen wir uns zunächst ansehen, wie Bildsensoren funktionieren. Ein Bildsensor besteht aus lauter kleinen Lichtsensoren, die nur die Menge des einfallenden Lichts messen – ohne Farben zu unterscheiden. 12 Megapixel bedeutet 12 Millionen solcher Lichtsensoren.

Um aus diesem Schwarzweiß-Sensor nun einen Farbsensor zu machen, liegt über dem Sensor eine Farbmaske, die das einfallende Licht nach Grün, Rot beziehungsweise Blau filtert. Die bei den meisten Bildsensoren verwendete Bayer-Maske unterteilt zwei mal zwei Pixel immer in zwei grüne sowie einen roten und einen blauen Pixel. Ein Sensor mit 12 Megapixeln Auflösung hat also sechs Millionen grüne sowie jeweils drei Millionen blaue und rote Pixel.

Beim sogenannten Demosaicing oder auch De-Bayering schließen die Bildverarbeitungsalgorithmen nun anhand der Helligkeitswerte der umliegenden andersfarbigen Pixel auf den RGB-Wert eines jeden Pixels zurück. Ein ganz heller grüner Pixel, der von "dunklen" blauen und roten Pixeln umgeben ist, wird also komplett grün. Und ein grüner Pixel neben komplett ausbelichteten blauen und roten Pixeln wird weiß. Und so weiter, bis wir ein Bild mit 12 Millionen RGB-Pixeln haben.

Bei höher auflösenden Sensoren sieht die Farbmaske allerdings anders aus. Beim sogenannten Quad-Bayer-Sensor – typisch im Bereich um die 50 Megapixel – sitzen unter jedem roten, grünen beziehungsweise blauen Bildpunkt jeweils vier Helligkeitspixel. Die 108-Megapixel-Sensoren gruppieren gar neun (3x3) Pixel unter einer Farbfläche, bei den 200-Megapixel-Chips sind es 16 (4x4) Pixel. Bei Sony heißt das dann Quad-Bayer, bei Samsung Tetra-, Nona- oder Tetra2pixel.

Während die Bildsensoren bezüglich der Helligkeit also tatsächlich eine Auflösung von bis zu 200 Megapixeln haben, bleibt die Farbmaske bei 12 Megapixeln stehen. Das ist auch kein Problem, da in der Wahrnehmung die Helligkeitsauflösung wichtiger ist als die Farbauflösung. Dennoch: Bei extrem hohen digitalen Zooms lässt die Farbauflösung irgendwann derart nach, dass es zu Bildfehlern kommt.

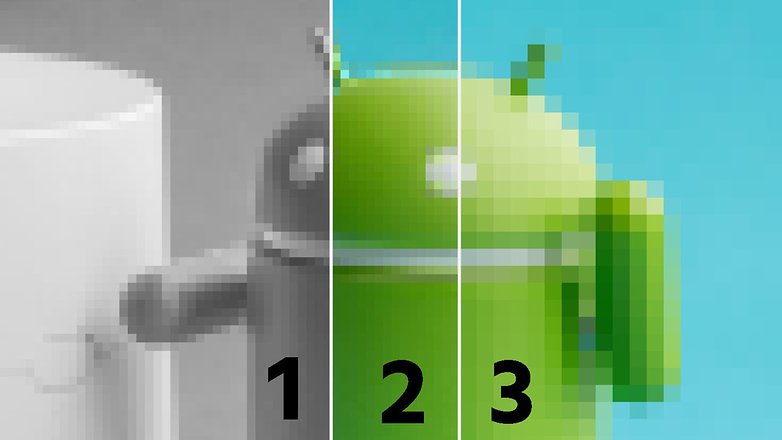

Als Beispiel haben wir hier ein Foto von einem kleinen Androiden bearbeitet. Links (1) seht Ihr ein Graustufen-Bild, rechts (3) ein RGB-Bild mit geviertelter Auflösung. Das mittige Bild haben wir aus beiden linken und rechten Bildern zusammengesetzt – und auf den ersten Blick sieht das Ergebnis sehr gut aus. Beim genaueren Hinsehen ist jedoch der Übergang zwischen Grün und Blau am Scheitel des Androiden unsauber. Und genau an solchen Übergängen treten Artefakte auf, wenn man zu weit in einen Sensor hineinzoomt, bei dem die Farbmaske niedriger auflöst als der Sensor selbst. Samsung hatte übrigens vermutlich genau deswegen auch bei seinem vielgescholtenen 1,1x-Telesensor im S20(+) und S21(+) einen 64-Megapixel-Sensor mit für diese Auflösung untypischer RGB-Matrix eingesetzt.

Unterm Strich ist rein vom Datenblatt schwer auszumachen, wie sich die Bildqualität bei Kameras verhält, zumal eine ganz entscheidende Rolle am Ende auch an die Algorithmen der Hersteller geht. Und auch das sogenannte Re-Mosaicing ist eine große Herausforderung. Denn bei Sensoren mit 2x2-, 3x3- oder 4x4-Bayermasken müssen – anders als beim normalen De-Mosaicing – die Farbwerte über immer größere Sensorbereiche und mit immer größerer Komplexität interpoliert werden.

Auf der anderen Seite bringen aber auch die immer größeren Sensoren Probleme mit sich. Um die Objektive kompakt zu halten, müssen die Hersteller Linsen verbauen, die das Licht immer extremer brechen und damit gerade am Bildrand Probleme mit chromatischen Aberrationen und anderen Artefakten bekommen. Und auch die geringe Schärfentiefe stellt im Nahbereich ein Problem dar.

Es bleibt also spannend, und ich hoffe, Ihr fandet diese Reise in die Welt der extrem großen und extrem hochauflösenden Bildsensoren interessant. Wie sieht Eure Wunschkamera in einem Smartphone aus? Ich freue mich auf Eure Kommentare!

Ein Digitaler zoom, bei dem noch ausreichend viele Bildpunkte ohne Hochrechnung übrig bleiben, ergeben bei nicht allzu kritischer Sichtweise immer noch sehr sehenswerte Bilder. Aber man muß sich sicher sein, dass das Smartphone es auch so macht wie im Artikel beschrieben. Bei einem Test mit einem Samsung S 22 scheint das nicht so zu sein. Die Bilder mit dem 2 fach digitalzoom mit dem Hauptsensor waren eindeutig schlechter als ohne zoom, 2,9 facher digitalzoom sehr schlecht und 3 fach zoom ? wieder ein sehr gutes Foto. Da schaltet das Gerät auf das optische Tele um und man erkennt, das auch dieser kleine Sensor mit nur 10 Mio Bildpunkte gute, deutlich bessere Fotos liefert als 2,9 fach zoom auf den Hauptsensor. Eigentlich nicht nachvollziehbar, weil 2 fach digital wie im Artikel beschrieben 25 % der Bildpunkte, also ca. 10 Mio hat. Mögliche Lösung : im August 2023 gab es eine Meldung, dass das S 23 ein Fotoupdate erhalten hat, nachdem es so arbeiten soll wie Apple 14 ( achtung , ältere Modelle). Anscheinend rechnet das S22 erst von 50 Mio auf die Ausgabegröße vom 12 Mio herunter und macht erst dann den digitalen Zoom

Warum verwendet verwendet man überhaupt Quad-, neunfach- oder sechszehnfach Bayermasken? Man verschwendet eine mögliche höhere Farbauflösung, und Vorteile sind für mich nicht erkennbar. Dass die Herstellung einfacher Bayermasken bei den höherauflösenden Sensoren technologisch problematisch ist, erscheint mir unwahrscheinlich. Eher schon, dass die Demosaicing-Algorithmen dann womöglich zu viel Rechenlast erzeugen. Oder haben diese groben Farbmasken tatsächlich Vorteile?

Schon bei einfachen Bayermasken sind 2/3 der Farbwerte interpoliert und keine echten Messwerte, und die groben Bayerfilter verschlechtern diese Situation nur noch mehr.

Digitalzoom ist optischem Zoom i.d.R. qualitativ unterlegen, aber dafür kostet er auch fast nichts. Weder braucht man eine Mechanik zum Verschieben der Linsen (und den dafür nötigen Bauraum), noch ein weiteres Kamerasystem. Wenn die Möglichkeit dafür besteht, sollte man sie auch nutzen.

Meine Einstellung hierzu ist nicht anders als zu den häufig kritisierten 2 Megapixel Macrosensoren, die auch Massenprodukte ohne wesentlichen Einfluss auf den Verkaufspreis sein dürften.

Lieber habe ich ein Feature mit zweifelhafter Qualität, das ich ja nur nicht nutzen muss, wenn die Qualität mir nicht reicht, als ein solches Feature auch dann nicht zu haben, wenn ich es eigentlich bräuchte, die Qualität dabei aber zweitrangig ist.

Nur sollte ein solches Feature dann auch nicht viel kosten.

Von einer vierten (virtuellen) Kamera zu reden, halte ich aber für übertrieben. Herkömmliche Kameras mit variablem Zoom wären dann ja unendlich viele Kameras. Das behauptet aber eigentlich niemand.

"Wenn die Möglichkeit dafür besteht, sollte man sie auch nutzen."

Die Möglichkeit besteht bei jedem digitalen Foto - per Cropping; seit es Digitale Fotos gibt. Jede lieblos programmierte Foto-App sollte diese Möglichkeit (per digitalem "Zoom" und/oder in der Nachbearbeitung per Crop) haben. Ist dies nicht der Fall, so lässt sich nahezu jede x-beliebige Nachbearbeitungs-App dazu nutzen.

------

"Das iPhone 14 Pro hat vier Kameras, ... Allerdings sind auf der Rückseite nur drei Kameras sichtbar."

Scheinbar meint Apple, (potentielle) Kunden können nicht mal bis 3 zählen und schlucken jede noch so absurde Dreistigkeit als Innovation und Next Best Thing. Fantasie für´s Datenblatt.

"Die Möglichkeit besteht bei jedem digitalen Foto - per Cropping; seit es Digitale Fotos gibt."

Schon richtig, aber nicht unter Beibehaltung der Auflösung (Nach Aufhebung eines zuvor bestehenden Pixelbinnings, allerdings auf Kosten des Störabstandes)

Beim herkömmlichen Cropping bleibt der Störabstand, aber die Auflösung verringert sich.

Bei guten Lichtverhältnissen macht sich der verringerte Störabstand bei voller Auflösung aber nicht bemerkbar.

Das funktioniert natürlich auch mit Geräten anderer Hersteller, sofern sie einen hochauflösenden Sensor besitzen. Man hebt das Pixelbinning auf, schiesst das Foto und schneidet aus der Mitte einen Teil heraus, der der gebinnten Auflösung des Sensors entspricht.

Das hat Apple mit ein paar Zeilen Software automatisiert, und hat ein neues Feature, das so gut wie nichts kostet.

Ohne Pixelbinning kommt ein 200MP Gerät auf ein Vielfaches an Zoomstufen - mit x-beliebiger Software. Wie ich bereits sagte.

Da Apple auch Trendsetter im Marketing ist, muss befürchtet werden, dass 200MP Knipsen zukünftig 10 "virtuelle" Kameras besitzen.

Welchen Bären kann man dem Kunden noch aufbinden, scheint Apple zu denken. Der Apple Kunde ist aber mehrheitlich offensichtlich kritiklos und kauft.

@dieCrisa

Das mag in der Theorie stimmen, aber nicht in der Praxis. Die Pixel der 200MP Sensoren sind so extrem klein, dass sie selbst bei Sonnenschein ziemlich unbrauchbar sind und man um Pixel-Binning quasi gar nicht herumkommt.

Zudem sind die billigen Plastiklinsen in Smartphones schlicht und rein optisch überhaupt nicht in der Lage solche Auflösungen zu schaffen. Das ist einfach unmöglich. Objektive für Kameras mit 40+ MP kosten nicht grundlos vier- oder teils fünfstellige Beträge. Die Linsen in Smartphones packen wenn überhaupt die klassischen 12MP (und selbst das ist sehr unwahrscheinlich). Alles darüber ist pures Wunschdenken und Marketing.

Zudem ist es ziemlich dämlich zu behaupten, dass Apple den Leuten einen Bären aufbindet. Denn anders als so manch anderer Hersteller beschreibt Apple EXAKT, wie die "vierte" Kamera entsteht. Mehr Transparenz geht da nicht und mit Transparenz bindet man keinen Bären auf...

Die Frage, welche Pixelzahlen bei solchen Sensoren überhaupt sinnvoll sind, hat mich auch beschäftigt, und ich möchte daher folgende Überlegungen in den Raum stellen:

Nach dem Raleigh-Kriterium ist der Durchmesser eines "Beugungsscheibchens":

d=2,4392*Wellenlänge*Blendenzahl

Für grünes Licht bei einer angenommenen Blendenzahl von 2 also:

d=2,4392*0,55um*2 = 2,68 um

Nach Raleigh leicht lassen sich zwei solcher Beugungsscheibchen gerade noch als getrennt wahrnehmen, wenn sich ihre Maxima mindestens im Abstand dieses Durchmessers befinden. Um eine (eindimensionale) Abtastung eines solchen hell-weniger hell-hell-Musters durchzuführen, sind aber nach dem Nyquist-Kriterium (praktisch) 2,3 Pixel erforderlich.

Der Mittenabstand (und damit ihre Größe abzüglich des halben Abstandes) dieser Pixel wäre damit:

2,68 um / 2,3 = 1,165 um.

Mehr Pixel sind möglich, bringen aber keinen zusätzlichen Auflösungsgewinn.

Der Samsung-Sensor hat bei voller Auflösung eine Kantenlänge von 0,64 um, bei vierfach Pixelbinning von 1,28 um und wäre damit geringfügig schlechter als die optische Auflösung der Linsen.

Eine Sensorauflösung von 50 Megapixel wäre demnach eine noch sinnvoll nutzbare Auflösung (bei etwa 1,2 um Kantenlänge).

Wird diese Kantenlänge nicht unterschritten, kann der dann größere Sensor natürlich auch viel mehr Pixel haben, sofern man ihn dann noch vollständig ausleuchten kann.

Ob Glaslinsen hierbei noch entscheidende Verbesserungen bringen halte ich für fraglich. Möglicherweise aber Metalinsen, die dünn wie Papier hergestellt werden können (und damit würde auch der Kamerabuckel verschwinden) und vielversprechend neue Eigenschaften mitbringen. So lassen sich prinzipiell damit auch Freiform-Optiken realisieren, also z.B. auch Linsen mit mehreren Brennpunkten usw.

Zur oben in den Raum gestellten Frage nach dem Sinn von Quad, neunfach- oder sechszehnfach Bayermasken bin ich zu folgender Überlegung gekommen:

Viele Sensoren unterstützen Pixelbinning bereits auf dem Chip, und das wird offensichtlich auch genutzt.

Addiert man aber bei einer einfach Bayermaske die Signale von vier nebeneinander liegenden Farbpixeln, vernichtet man die zuvor durch die Bayermaske gewonnene Farbinformation der einzelnen Pixel wieder zu einem reinen Helligkeits- oder Graustufensignal, das zudem nur ein Drittel des Lichts nutzen würde.

Würde man das Pixelbinning dagegen in Software realisieren, hätte man bei einem gebinnten Pixel sogar drei echte Messkanäle und könnte auf die Approximation der jeweils fehlenden Farben durch Demosaicing verzichten (die gebinnten Einzel-Pixel wären dann Subpixel, ähnlich wie bei einem Display). Lediglich für die volle Auflösung wäre Demosaicing oder Debayering weiterhin nötig, die Farbauflösung bliebe aber erhalten.

Quelle:

https://de.m.wikipedia.org/wiki/Beugungsscheibchen

Apples Transparenz:

"Dieser neue Tele-Zoom liefert mit den mittleren 12 Megapixeln des Quad-Pixel Sensors Fotos in voller Auflösung und 4K Videos ohne digitalen Zoom."

Ohne digitalem Zoom. Aha.

Solang es transparent vermarktet wird, ist es kein "freches Marketing". Apple beschreibt es schließlich genau wie sie es machen.

Wenn man es hingegen so macht, wie Samsung beim S20 und S21 - das geht mMn gar nicht. Auch wenn die Ergebnisse in der Praxis nicht sehr groß sind.

Was aber kompletter Unsinn ist und bleibt, ist Pixel-Binning. Ganz besonders mit 16 Pixeln. Denn da man zwischen jedem Pixel einen Abstand hat, sind die zusammengerechneten Pixel VIEL kleiner, als das auf dem Papier angegebene. Bei diesen 200MP-Sensoren hat man auf dem Papier dann 2.56um Pixel, in der Praxis sind es aber wahrscheinlich deutlich unter 2.0um.

-

Admin

-

Staff

07.10.2022 Link zum KommentarDie meisten modernen Sensoren müssten aber inzwischen dank Mikrolinsen, rückseitiger Belichtung & Co. weitgehend 'gapless' sein, oder? Soweit ich weiß, sind die Lücken zwischen den Pixeln zu vernachlässigen, oder hast Du da andere Infos?

Wenn man sich mal Apples Zahlen ansieht, dann ist das aber überhaupt nicht so.

Der Tele im 14 Pro hat absolut gar keine Veränderungen erfahren und trotzdem soll er im Lowlight Dank der Photonic Engine bis zu 2x besser sein.

Der Ultraweitwinkel ist 3x besser, da Photonic Engine + doppelt so großer Sensor.

Der Weitwinkel auf der anderen Seite hat exakt die gleiche 2x Verbesserung, wie der Tele. Rein logisch bedeutet das buchstäblich:

Ohne die Photonic Engine hat der neue Weitwinkel EXAKT die gleiche "Leistung", wie der Sensor im 13 Pro und das obwohl dessen Sensor "nur" 1.9um hat, gegenüber den virtuellen Pseudo-2.44um Pixel. Apple gibt schlicht zu, dass sich die Leistung des Sensors selbst kein bisschen verbessert hat und das bedeutet, dass die 2.44um effektiv nur genau die gleiche Leistung bieten, wie 1.9um physische Pixel. Und die Praxis unterstreicht diese Vermutung, denn wenn man ProRAW mit den 48MP außer acht lässt, hat sich so gut wie nicht getan und die Lowlight-Performance ist quasi identisch, was bei einem 65%(!) größeren Sensor nicht der Fall sein sollte.

Und bei ganzen 16 Pixeln sollte das dann noch viel krasser sein. Die Pseudo-2.56um haben in der Praxis da wahrscheinlich kaum mehr Leistung, als ein Sensor mit echten 1.4um Pixeln, obwohl sie auf dem Papier 3,3x größer sind.