Google I/O: Android-Smartphones lernen sehen und sprechen

Open AI hat am Montagabend mit seinem neuen Modell GPT-4o versucht, Google den Wind aus den KI-Segeln zu nehmen. Die neueste ChatGPT-Version soll nicht nur Text verarbeiten, sondern auch nahtlose Konversationen führen, Emotionen erkennen und Eingaben via Live-Video verarbeiten können. Jetzt schlägt Google auf der Entwicklerkonferenz I/O zurück, mit einer futuristischen KI-Breitseite.

Wie stark ist Googles KI-Modell?

Was ChatGPT bei OpenAI, das ist Gemini bei Google. Und zumindest beim Quartett-Spiel liegt Googles mächtigstes KI-Modell namens Gemini Pro 1.5 deutlich vor den aktuellen GPT-4-Modellen. Gemini Pro 1.5 kann laut Google nämlich 1 Million Tokens verarbeitet, während bei den diversen GPT-4-Modellen maximal 128.000 Tokens möglich sind. Diese Token-Anzahl bezieht sich darauf, wie viele Informationen das jeweilige Modell für die aktuelle Aufgabe präsent haben kann.

Allerdings sagt das ebensowenig etwas über die Rundenzeit auf der Nordschleife aus wie die PS-Zahl eines Sportwagens. Es kommt beispielsweise auch darauf an, wie effektiv die Informationen verarbeitet werden können; also wie effektiv beispielsweise aus Videos Informationen extrahiert und zur Weiterverarbeitung bereitgestellt werden.

Laut Google lassen sich mit 1 Million Tokens beispielsweise 1.500 PDF-Seiten erfassen, 30.000 Zeilen Code oder eine Stunde Video. Ausgewählten Entwicklern will Google in verschiedenen Entwickler-Umgebungen demnächst ein Gemini-Modell mit 2 Millionen Tokens zur Verfügung stellen. Und der Alphabet-Chef Sundar Pichai ruft ein klares Ziel aus: "Infinite Context", also quasi das totale Gedächtnis für KI-Modelle.

Welche Google-Produkte bekommen neue KI-Features?

Soweit die Theorie. Aber was wird sich denn jetzt ändern bei den diversen Google-Diensten? Auf der Google I/O gab es hier ein paar konkrete Ankündigungen, einige davon sogar ab sofort. Andere Produkte wurden mit eher weichen Release-Terminen à la "in den nächsten Monaten" angekündigt, und häufig ist auch nicht klar, ob der Rollout der KI-Features für den globalen Markt oder zunächst nur für die USA gilt.

Außerdem hat Google auch seinen Bezahldienst "Gemini Advanced". Wer beispielsweise das AI-Premium-Paket des Google-One-Dienstes für 22 Euro im Monat abgeschlossen hat, bekommt einige der Features früher – oder überhaupt erst. Ab sofort gibt's beispielsweise Zugriff auf Gemini Pro 1.5 in 35 Sprachen, die Erweiterung auf 2 Millionen Tokens kommt "irgendwann später dieses Jahr".

Kurz und knapp: Googles KI-Portfolio ist ein wirrer Flickenteppich, und ich fürchte, das wird sich nicht sobald ändern. Dann mal auf ins Getümmel!

- Kurz vor der Google I/O vorgestellt: Pixel 8a im ersten Test

Google Workspace: Willkommen, KI-Kollegen

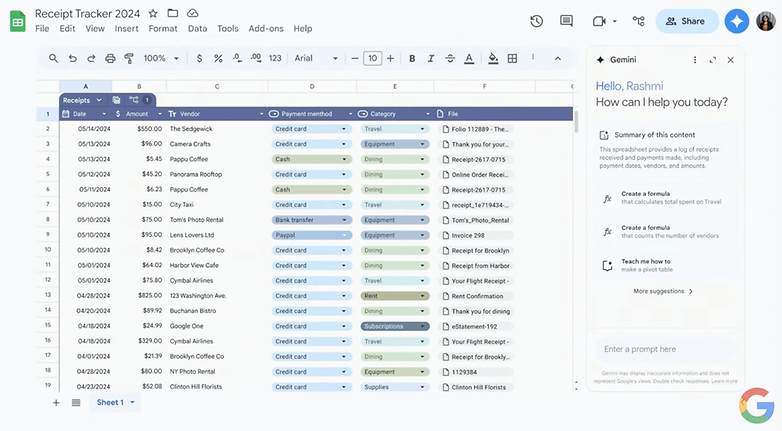

Google Workspace, das ist ein breiter Strauß an Office-Anwendungen von Google Sheets über Google Presentations bis hin zu Google Mail natürlich. Bereits im letzten Jahr haben wir auf der Google I/O den Gemini-Assistenten präsentiert bekommen, der Texte schreiben und smarte Tabellen voller Formeln oder Präsentationen basteln sollte. Englischsprachige Google-Accounts konnten mit Gemini Advanced die Features bereits nutzen, ab kommendem Monat soll das sogenannte Side Panel dann "generally available" sein. Ob damit verschiedene Sprachen oder auch Nicht-zahlende Nutzer gemein sind? Wurde nicht präzisiert.

Cool ist aber, dass sich künftig übergreifend mit dem Gmail-Postfach sprechen lässt. Habt Ihr verschiedene Handwerker-Angebote bekommen, dann sucht Euch die künstliche Intelligenz die unterschiedlichen Konditionen und möglichen Zeiträume heraus, fasst diese zusammen und bringt Euch per Knopfdruck direkt an die richtige Stelle, um wahlweise Rückfragen zu stellen oder direkt zu- oder abzusagen. Dieses spezielle Feature soll übrigens ab "Juli für alle Nutzer" kommen.

Spannend ist bei Google Workspace noch, dass die KI-Features künftig über verschiedene Tools hinweg arbeiten. Auf der Keynote gab es das Beispiel einer freiberuflichen Fotografin, deren E-Mail-Postfach vor ungelesenen Nachrichten mit Rechnungen überquillt. Im Side Panel kommt dann direkt der Vorschlag: Google-Drive-Verzeichnis mit dieser Rechnung und 37 weiteren anlegen, dazu ein Spreadsheet mit einer Übersicht und Klassifizierung der Rechnungen. Das coole: Nach Zustimmung wird dieser Vorgang nicht nur einmal ausgeführt, sondern direkt als Automation angelegt. Diese Multi-Plattform-Automationen kommen allerdings nicht mit dem Side-Panel, sondern im September – und auch erstmal nur zu Labs-Usern, also quasi Beta-Testern. Merkt Ihr was?

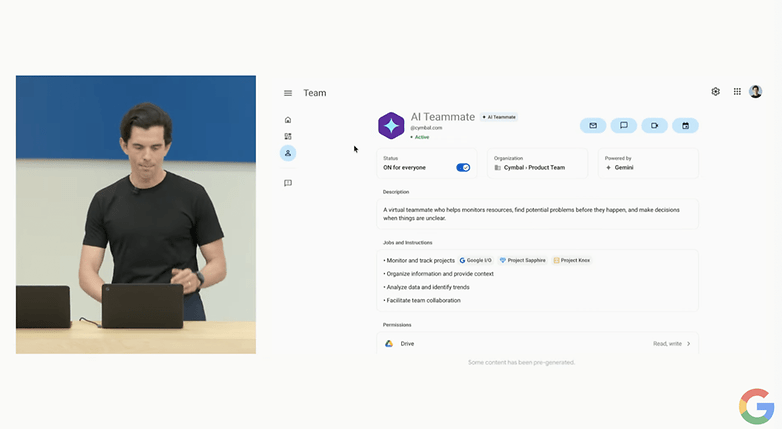

Ab 2025 wird's wild

Auch für kommendes Jahr hat Google bereits ein paar Ankündigungen auf Lager gehabt. So soll es künftig möglich sein, in Firmen-Accounts KI-Teammitglieder hinzuzufügen – inklusive Job-Titel, Status, Teameinheit und natürlich Name. Diese KI-Angestellten könnt Ihr dann in Google Chats hinzufügen, in Drive-Verzeichnisse teilen, bei E-Mails auf CC setzen und so weiter. Und anschließend könnt Ihr Ihnen dann Aufgaben geben, die sich auf die verfügbaren Informationen beziehen. Auf die Frage "Sind wir 'on track' mit unserem Produktlaunch" erstellt der KI-Kollege eine Timeline und markiert direkt mögliche Probleme. Google verspricht auch einen 3rd-Party-Support, mit dem Firmen bestimmte Typen von KI-Kollegen vorkonfigurieren können.

Project Astra und persönliche KI-Agenten

Auch außerhalb der Google-Workspaces sollt Ihr künftig eigene KI-Mitarbeiter haben, quasi als persönliche Assistenten. Dabei handelt es sich um sogenannte "Agenten". Dieser Begriff bedeutet in diesem Zusammenhang, dass sich hier ein KI-Modell eine logische Strategie zurechtlegen kann, und nach einem bestimmten Plan handelt. So könnt Ihr beispielsweise sagen: "Ich möchte die gestern online gekauften Schuhe zurücksenden." Anschließend sucht ein Agent in Euren E-Mails nach der passenden Rechnung, löst über den betreffenden Online-Shop einen Rückversand aus und spuckt Euch direkt das Rückversand-Label aus.

Noch spektakulärer war die Demo von Project Astra, die laut Google in Echtzeit und ohne Schnitte auf einem Smartphone abgefilmt wurde. Nacheinander wurden hier per Kamera in einem Büro erst Gegenstände gesucht, die Geräusche machen, ein Bestandteil eines Lautsprechers erklärt, eine Alliteration zu einer Stiftsammlung generiert, das auf dem Computerbildschirm im dargestellten Code genutzte Verschlüsselungsverfahren erläutert und beim Blick aus dem Fenster das Londoner Viertel erkannt, in dem das Büro steht. Der Clou: Im Anschluss an das Video mit zahlreichen Schwenks konnte die KI auch die Frage beantworten, wo die Brille abgelegt war.

Apropos Brille: "Stellt Euch das mal mit einer smarten Brille vor!", rief der Deepmind-Gründer Demis Hassabis ins Publikum, der diesen Teil der Präsentation halten durfte.

Google-Suche bekommt KI-Boost

Ab heute rollt Google in den USA einen ganzen Schwung neue Funktionen für die Google Suche aus – bis Ende 2024 sollen die Features mehr als einer Milliarde Nutzer zur Verfügung stehen. Herzstück der neuen Google-Suche sind die sogenannten "AI Overviews", die stark an die App Perplexity erinnern. Hier fasst Google bestimmte Informationen rund um ein Thema auf einem dynamischen Bildschirm zusammen und zeigt dazu Links auf die jeweiligen Quellen.

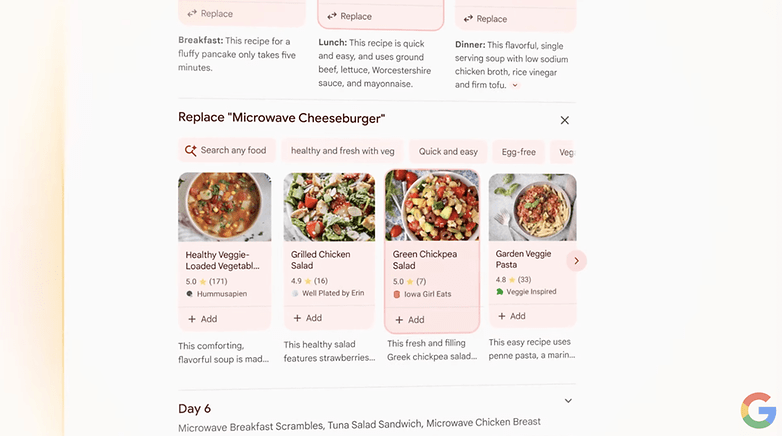

Wer beispielsweise nach einem Ernährungsplan sucht, bekommt einen Wochenplan präsentiert mit unterschiedlichen Rezepten – und weiterführenden Links. Wenn ein Rezept nicht passt, lässt es sich per Klick schnell austauschen. Für komplexeres Feedback gibt's ein Textfeld zum Eintippen von Prompts à la: "Integriere mehr vegetarische Optionen". Wichtig ist dabei, dass die Google-Suche immer den Kontext verstehen soll. Neben Rezepten sollen diese AI Overviews zum Start auch Restaurant-Tipps beinhalten, danach folgen Partys, Dates, Trainingspläne, Reisen, Shopping und mehr.

Eine Besonderheit bei der Google-Suche ist auch, dass sich direkt komplexe Sachverhalte beschreiben lassen. Ihr müsst also nicht erst nach einem Ernährungsplan fragen, sondern könnt direkt eingeben, dass die Mahlzeiten schnell und mit ausschließlich einer Mikrowelle zubereitbar sein sollen.

Multimodale Suche mit Videos

Künftig soll es auch möglich sein, nicht nur per Text, sondern auch mit Videos und Sprache zu suchen. Auf der Eröffnungskeynote gab es dafür ein eindrucksvolles Beispiel auf der Bühne. Rose Yao filmte einen Plattenspieler ab, bei dem der Tonarm stets auf die Parkposition zurücksprang. Auf die Frage: "Was ist hier das Problem?" hin erkannte die Google-Suche das Plattenspieler-Modell sowie das Problem und konnte direkt auf Webseiten mit Lösungsvorschlägen verweisen. Wann diese multimodale Suche per Video und Sprache ausgerollt wird, bleibt allerdings ein Geheimnis.

Android 15 mit viel KI

Irgendwo inmitten von 121 Erwähnungen von "AI" hat Google auch kurz über das kommende Android 15 gesprochen. Im Fokus standen allerdings auch hier – Überraschung – KI-Themen. Bereits bekannte KI-Features wie Circle to Search sollen bis Ende 2024 auf 200 Millionen Android-Geräten zur Verfügung stehen. Außerdem will Google den Google Assistant durch Gemini ersetzen – und Ihr könnt dann direkt Texte, Sprache, Bilder und Videos ein- und ausgeben. Dazu verspricht Google auch eine multimodale Version von Gemini Nano. Diese Gemini-Version läuft lokal und eignet sich daher besonders für sensible Inhalte. Verfügbar soll sie später dieses Jahr auf Pixel-Smartphones sein und beispielsweise Scam-Anrufe erkennen oder Blinden den Bildschirminhalt erklären.

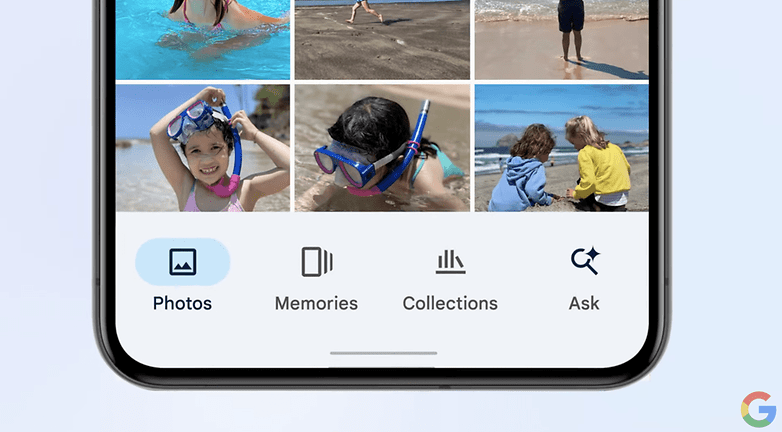

Google Photos soll ebenfalls neue KI-Features bekommen. So könnt Ihr beispielsweise mit "Ask Photos" irgendwann "ab Sommer" mit Eurer Fotosammlung sprechen und beispielsweise fragen können: "Was war nochmal das Kennzeichen von meinem Auto?" Die KI errät dann, welches Auto wohl Euch gehört und präsentiert Euch ein Bild vom Nummernschild. Ein anderes Beispiel aus der Präsentation war die Frage: "Wann hat meine Tochter Schwimmen gelernt?". Per Kommando ließ sich dann auch direkt eine Bilderserie mit den Schwimm-Fortschritten generieren.

Außerdem kommt eine Gemini-App auf Android, die – ganz wie das am Montag vorgestellte OpenAI-Modell GPT-4o auch natürliche Konversationen erlauben soll. Und ja, auch hier soll es möglich sein, die gerade sprechende KI zu unterbrechen, wenn das Gespräch in eine falsche Richtung geht. Angeblich soll ein Anpassen an die Sprachmuster des Nutzers die Konversationen besonders menschlich machen. Auch hier vertröstet uns Google auf den Sommer.

Ob die ab 15. Mai verfügbare Android 15 Beta 2 bereits irgendwelche neuen KI-Features beinhaltet? Wir werden's ausprobieren.

KI-Kreativität von Video bis Musik

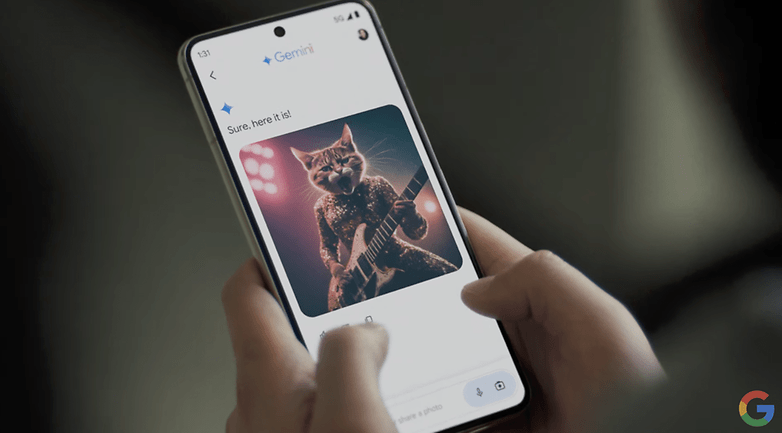

Natürlich durften auch diverse Kreativ-Werkzeuge mit KI-Support nicht fehlen. Was wäre schließlich die KI-lastige Keynote eines Internet-Giganten ohne Katzenbilder?

- Music AI Sandbox soll Künstlern neue Kreativ-Werkzeuge an die Hand geben. Wyclef Jean probierte beispielsweise begeistert das Übertragen von Musikstilen auf bestehende Tracks aus, und der Remix-König Marc Rebillet freute sich über den KI-Kollegen, der leere Loops füllt und spannende Anregungen gibt.

- Mit Imagen 3 könnt Ihr künftig noch realistischere Katzenbilder generieren können. Dabei sollen die Prompts noch akkurater verstanden werden, und auch das Generieren von Texten beispielsweise für Logos soll zuverlässig funktionieren. Interessierte Nutzer können sich ab heute auf labs.google für das Feature in ImageFX bewerben.

- Klar, auch Videogeneration war ein Thema. Mit dem KI-Modell Veo lassen sich aus Text, Fotos und Videos 1080p-Videos in vielfältigen cinematischen Stilen generieren. Der Filmemacher Donald Glover ist hier gerade dabei, einen Kurzfilm zu "drehen" – aber auch hier musste Google auf ein "bald" vertrösten.

- Im der experimentellen Anwendung Notebook-LM wird es künftig möglich sein, auf Basis der dort hinterlegten Informationen Dialoge zu generieren zwischen zwei KIs. Auf der Keynote gab es eine Demo, bei der sich zwei Personen über die Newtonschen Gesetze unterhalten – und zwar per Sprache. Über den "Join"-Button ist es jederzeit möglich, in das Gespräch einzusteigen, und dieses in eine beliebige Richtung zu lenken, sodass die etwas trockene Physik-Diskussion die Physik-Grundlagen dann anhand des Beispiels "Basketball" erklärt.

Google vs OpenAI: Wer hat die große KI-Woche gewonnen?

Wer hat sie denn nun, die bessere KI: Google oder OpenAI? Ohne Gemini Pro 1.5 oder das die multimodalen Aspekte von GPT-4o voll ausprobiert zu haben, ist das natürlich schwer zu sagen. Aber eines ist klar: OpenAI hat einen Schwung von Sprachmodellen sowie eine Smartphone- und nun auch eine Desktop-App – und klar, die API.

Und Google? Google betreibt neben seinen KI-Modellen beispielsweise mit Google und YouTube mit 275 Milliarden monatlichen Besuchen die beiden meistbesuchten Webseiten, die mit drei Milliarden Installationen meistgenutzte Office-Suite oder das mit 71 % Marktanteil meistgenutzte Mobil-Betriebssystem der Welt. Google wird also anders als OpenAI viel geringere Hürden haben, seine Modelle dorthin zu bringen, wo die Anwendungsfälle sind.

Es seit denn, am 10. Juni bewahrheiten sich die Gerüchte und Googles großer Konkurrent verkündet auf seiner eigenen Entwicklerkonferenz eine Partnerschaft mit OpenAI. In weniger als einem Monat werden wir's erfahren, auf Apples WWDC – dann hoffentlich mit weniger Vertröstungen auf "irgendwann".

Ich bin ehrlich... ich habe noch kein Apple, Samsung oder auch Google Event gesehen, das mich so fasziniert hätte wie dieses Google I/O.

Es dürfte bekannt sein, dass ich zwar ebenfalls Skeptiker bin, aber durchaus verstanden habe, dass eine funktionierende Kommunikation auf globaler Basis, ganz gleich ob mit einem Menschen oder einer künstlichen Intelligenz, voraussetzt, dass man etwas von sich preisgibt. Ich habe entsprechend absolut keine Datenschutzbedenken, wenn ich künstliche Intelligenz(en) in meinem Alltag verwende, weil ich einerseits gewissenhaft entscheide, welche personenbezogenen Daten ich preisgebe und andererseits schon ein bisschen darauf vertraue, dass besonders große Tech-Konzerne, sagen wir "ihr möglichstes tun", um meine Daten zu schützen.

Auf Basis dieser Selbsteinschätzung kann ich es kaum erwarten, Gemini auszuprobieren. Aktuell habe ich die App per SideLoad auf mein Pixel geladen und war erstaunt, dass die meisten Dinge tatsächlich bereits funktionieren - sogar auf deutsch - aber mein Google Play immer noch sagt, dass Gemini noch nicht in meinem Land verfügbar ist.

Davon abgesehen bin ich zu 100% fasziniert, was dieses KI bereits kann und freue mich auf viele weitere Funktionen in der Zukunft. Diese Google I/O hat mich zu 100% darauf gebracht, mit das Google Pixel 9 Ende Q3/Anfang Q4 zuzulegen und zum ersten mal spiele ich tatsächlich mit dem Gedanken, mal ein Chrome Book auszuprobieren, besonders weil Windows ja bald ein CloudOS wird und nur noch als Abomodell zur Verfügung stehen wird und ich Linux bis heute nicht allzu viel abgewinnen kann.

Ich kann es kaum in Worte fassen, aber diese I/O hat mich extrem begeistert.

Natürlich werden unsere Datenschützer wieder dem ein oder anderen Feature einen Riegel vorschieben und natürlich steckt die KI-Entwicklung trotz solch beeindruckender Features immer noch in den Kinderschuhen. Aber ich kann kaum erwarten zu sehen, was da noch kommt.

Angst bezüglich Gemini teile ich nicht. Und allein die Tatsache, dass Gemini viele Features offline unterstützt, ist faszinierend.

Interessanter Artikel von dir, Stefan. Danke!

Ich bin als geborener Skeptiker da natürlich insofern vorsichtig gegenüber AI, als dass ich glaube, dass sie nur dann gut funktionieren kann, je mehr ich zuvor von mir, meinem (Ab-)Neigungen, meinen Schwächen, meinen Wünschen und Vorlieben preisgegeben habe.

Wenn dem tatsächlich so ist, dann ist das natürlich zu 100 Prozent mit Googles grundsätzlichem Geschäftskonzept kompatibel. Von daher wundert es mich nicht, dass gerade Google da ziemlich federführend ist und sich schon jetzt die Hände reibt.

So gesehen bin ich als Protagonist der Vorsicht da eher geneigt mal abzuwarten, wie die Dinge letztendlich umgesetzt werden und vor allem, ob Apple das Ganze etwas privater handhabt bzw umsetzt. Irgendwie ist die Materie wahnsinnig interessant, aber irgendwie doch auch ziemlich beängstigend, finde ich. Dem Spion Google habe ich noch nie so wirklich vertraut. Andererseits ist eine Welt ohne Google-Dienste wie Maps und Youtube auch für mich nicht mehr vorstellbar.